{학습 목적}

04 파트에서는 판다스에 대해서 학습한다.

판다스에 대해서 학습하는 이유는 앞서 설명했듯이, 실제로 ML 모델을 생성하고 예측을 수행하는 데 있어서 ML알고리즘이 차지하는 비중보다 넘파이, 판다스와 같이 데이터를 전처리하는 과정이 더 중요하다고 할 수 있기 때문이다. 그 중 판다스는 넘파이보다 데이터 핸들링을 손쉽게 할 수 있다.

판다스(Pandas): 행과 열로 이루어진 2차원 데이터를 효율적으로 가공/처리할 수 있는 다양한 기능을 제공하는 라이브러리

판다스는 파이썬의 리스트, 컬렉션, 넘파이 등의 내부 데이터 뿐만아니라 csv파일을 쉽게 dataframe으로 변경해 데이터의 가공/분석을 쉽게 수행할 수 있게 해준다.

DataFrame : 판다스의 핵심 객체로 여러개의 행과 열로 이루어진 2차원 데이터를 담는 데이터 구조체

Index : 개별 데이터를 고유하게 식별하는 Key값, Series와 DataFrame은 모두 Index를 key값으로 갖는다.

Series: 칼럼이 하나뿐인 데이터 구조체, dataframe은 여러개의 series로 이루어져있다.

[판다스 시작 - 파일을 DataFrame으로 로딩, 기본 API]

판다스는 다양한 포맷으로 된 파일을 DataFrame으로 로딩할 수 있는 편리한 API를 제공

- read_csv() : CSV(칼럼을 ',' 로 구분한 파일 포맷) 파일 포맷 변환을 위한 API

- read_csv(filepath_or_buffer, sep = ',',...)

- read_table(): CSV(칼럼을 '/t' 로 구분한 파일 포맷) 파일 포맷 변환을 위한 API

--> 이 둘의 기능은 큰 차이가 없으므로 read_csv()만 사용

- read_fwf() : 고정 길이 기반의 칼럼 포맷을 DataFrame으로 변환하기 위한 API

첫번째 칼럼 값이 DataFrame의 고유한 Index값

- DataFrame.head() : DataFrame의 맨 앞에 있는 N개의 로우 반환 (Default는 5개)

DataFrame의 행과 열 크기를 알아보기 위해서 shape 변수를 이용한다. (df의 행과 열을 튜플형태로 반환)

print('DataFrame 크기:', titanic_df.shape)

[output]

DataFrame 크기: (891, 12)

- DataFrame.info() : 총 데이터 건수와 데이터 타입, Null 건수를 알려주는 매서드

titanic_df.info()

[output]

<class 'pandas.core.frame.DataFrame'>

RangeIndex: 891 entries, 0 to 890 #행의 수 891

Data columns (total 12 columns): #열의 수 12

# Column Non-Null Count Dtype

--- ------ -------------- -----

0 PassengerId 891 non-null int64

1 Survived 891 non-null int64

2 Pclass 891 non-null int64

3 Name 891 non-null object

4 Sex 891 non-null object

5 Age 714 non-null float64 #Age의 891개의 데이터 중 714 non-null, 117 null

6 SibSp 891 non-null int64

7 Parch 891 non-null int64

8 Ticket 891 non-null object

9 Fare 891 non-null float64

10 Cabin 204 non-null object

11 Embarked 889 non-null object

dtypes: float64(2), int64(5), object(5) #2개의 칼럼이 float64, 5개 칼럼 int64, 5개 칼럼 object

memory usage: 83.7+ KB

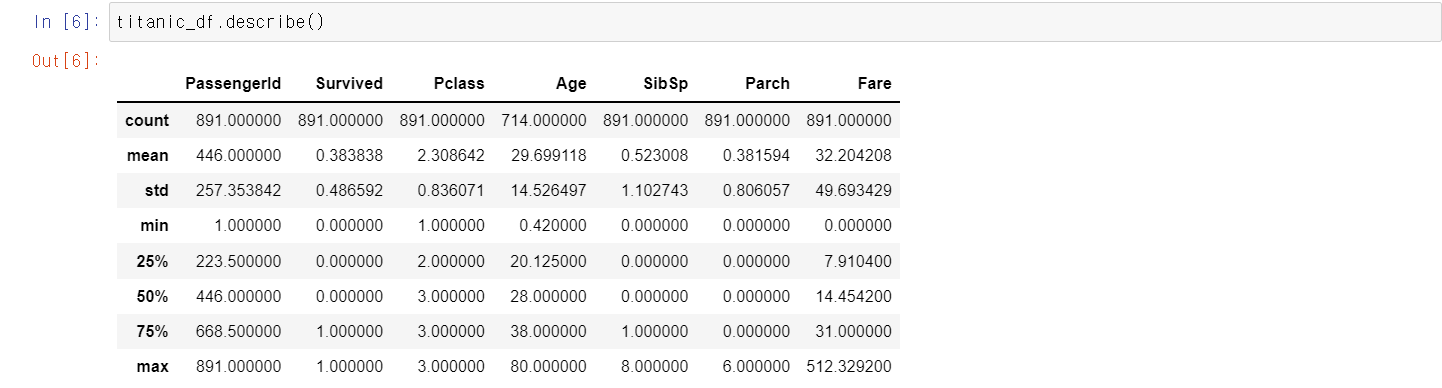

- Dataframe.descirbe() : 칼럼별 숫자형데이터 값의 n-percentile 분포도, 평균값, 최댓값, 최솟값을 나타내는 메서드

오직 숫자형 칼럼의 분포도만 조사하며 자동으로 object 타입의 칼럼은 출력에서 제외시킨다.

즉, 숫자형 칼럼에 대한 개략적인 데이터 분포도를 확인할 수 있게 한다.

count - not null 인 데이터의 갯수

mean - 전체 데이터의 평균값

std - 표준편차

min - 최솟값

max - 최댓값

Pclass 칼럼 값이 어떠한 분포로 구성되어있는지 알아보자

DataFrame의 []연산자 내부에 칼럼명을 입력하면 Series형태로 특정 칼럼 데이터세트가 반환된다.

df.value_counts(): 해당 칼럼값의 유형과 건수를 확인하는 메서드 --> 매우 유용한 함수!

value_counts = titanic_df['Pclass'].value_counts()

print(value_counts)

[output] #많은 값부터 순서대로 반환

3 491 #Pclass값 3이 491개

1 216

2 184

Name: Pclass, dtype: int64

반환된 series 객체가 어떻게 구성되어 있는지 5개의 로우만 추출해 보자

#DataFrame의 [] 내부에 칼럼명을 입력하면 해당 칼럼에 해당하는 Series객체 반환

titanic_pclass = titanic_df['Pclass']

print(type(titanic_pclass))

[output]

<class 'pandas.core.series.Series'>0 3

1 1

2 3

3 1

4 3

Name: Pclass, dtype: int64맨 왼족의 칼럼은 series의 해당 칼럼의 index값이다.

모든 Series와 DataFrame은 인덱스를 반드시 가진다.

단일 칼럼으로 되어있는 Series 객체에서 value_counts() 메서드를 호출하는 것이 칼럼별 데이터값의 분포도를 좀 더 명시적으로 파악하기 쉽다.

titanic_df의 Pclass칼럼만을 값으로 가지는 Series 객체에서 호출하여 반환값을 다시 확인해보자

value_counts = titanic_df['Pclass'].value_counts()

print(type(value_counts))

print(value_counts)

[output]

<class 'pandas.core.series.Series'>

3 491

1 216

2 184

Name: Pclass, dtype: int64value_counts()가 반환하는 데이터 타입 역시 series 객체이다.

이번에는 pclass 칼럼값이 0부터가 아닌 3,1,2 를 나타내고 있다.

이처럼 인덱스는 단순히 순차값과 같은 식별자만 할당하는 것이 아니라 고유성이 보장된다면 의미 있는 데이터값 할당도 가능하다.

즉, value_counts()는 칼럼 값별 데이터 건수를 반환하므로 고유 칼럼값을 식별자로 사용할 수 있다.

value_counts() 메서드를 사용할 때는 Null값을 무시하고 결괏값을 내놓기 쉽다는 점을 유의해야한다.

print('titanic_df 데이터 건수:', titanic_df.shape[0]) #튜플 형태의 0번째 index 값 == 데이터건수

print('기본 설정인 dropna = True로 value_counts()')

#value_counts()는 디폴트로 dropna = True이므로 value_counts(dropna = True)와 동일.

print(titanic_df['Embarked'].value_counts())#null 데이터를 제외하고 연산을 수행

print(titanic_df['Embarked'].value_counts(dropna = False))#null데이터를 포함하여 연산을 수행

[output]

titanic_df 데이터 건수: 891

기본 설정인 dropna = True로 value_counts()

S 644

C 168

Q 77

Name: Embarked, dtype: int64

S 644

C 168

Q 77

NaN 2

Name: Embarked, dtype: int64

[DataFramer과 리스트, 딕셔너리, 넘파이 ndarray의 상호 변환]

1. 넘파이 ndarray, 리스트, 딕셔너리 -> DataFrame으로 변환

일반적으로 DataFrame으로 변환 시 칼럼명을 지정해준다. (지정해주지 않으면 자동으로 칼럼명을 할당한다.)

판다스 DataFrame은 객체의 생성인자 data는 리스트, 딕셔너리, 넘파이 ndarray를 입력받고 생성인자 columns는 칼럼명 리스트를 입력받아서 쉽게 DataFrame을 생성할 수 있다.

DataFrame은 기본적으로 2차원 데이터이므로 2차원 이하의 데이터들만 DataFrame으로 변환될 수 있다.

1차원 형태의 리스트와 넘파이 ndarray로부터 DataFrame을 변환해보자.

1차원 형태이므로 칼럼명이 한 개만 필요하다!

import numpy as np

col_name1 = ['col1']

list1 = [1,2,3]

array1 = np.array(list1)

print('array1 shape:', array1.shape) #(3,)

#리스트를 이용해 DataFrame 생성.

df_list1 = pd.DataFrame(list1, columns = col_name1)

print('1차원 리스트로 만든 DataFrame:\n', df_list1)

#넘파이 ndarray를 이용해 DataFrame 생성.

df_array1 = pd.DataFrame(array1, columns=col_name1)

print('1차원 ndarray로 만든 DataFrame:\n', df_array1)

[output]

array1 shape: (3,)

1차원 리스트로 만든 DataFrame:

col1

0 1

1 2

2 3

1차원 ndarray로 만든 DataFrame:

col1

0 1

1 2

2 3

이번에는 2차원 형태의 데이터를 기반으로 DataFrame을 생성해보자

2행 3열 형태의 리스트와 ndarray를 기반으로 DataFrame을 생성하므로 칼럼명은 3개가 필요하다.

#3개의 칼럼명이 필요함

col_name2 = ['col1', 'col2', 'col3']

#2행 3열 형태의 리스트와 ndarray 생성한 뒤 이를 DataFrame으로 변환

list2 = [[1,2,3],

[11,12,13]]

array2 = np.array(list2)

print('array2 shape:', array2.shape)

df_list2 = pd.DataFrame(list2, columns = col_name2)

print('2차원 리스트로 만든 DataFrame:\n', df_list2)

df_array2 = pd.DataFrame(array2, columns = col_name2)

print('2차원 ndarray로 만든 DataFrame:\n', df_array2)

[output]

array2 shape: (2, 3)

2차원 리스트로 만든 DataFrame:

col1 col2 col3

0 1 2 3

1 11 12 13

2차원 ndarray로 만든 DataFrame:

col1 col2 col3

0 1 2 3

1 11 12 13

이번에는 딕셔너리를 DataFrame으로 변환해보자.

#key는 문자열 칼럼명으로 매핑, Value는 리스트형(또는 ndarray)칼럼 데이터로 매핑

dict = {'col1':[1,11], 'col2':[2,22], 'col3':[3,33]}

df_dict = pd.DataFrame(dict)

print('딕셔너리로 만든 DataFrame:\n', df_dict)

[output]

딕셔너리로 만든 DataFrame:

col1 col2 col3

0 1 2 3

1 11 22 33

2. DataFrame -> 넘파이 ndarray, 리스트, 딕셔너리로 변환

DataFrame을 넘파이 ndarray로 변환하는 것은 DataFrame객체의 values를 이용해 쉽게 할 수 있다.

이 변환은 매우 많이 사용되므로 반드시 기억할 것 !!

#DataFrame을 ndarray로 변환

array3 = df_dict.values #values를 이용

print('df_dict.values 타입:', type(array3), 'df_dict.values shape:', array3.shape)

print(array3)

[output]

df_dict.values 타입: <class 'numpy.ndarray'> df_dict.values shape: (2, 3)

[[ 1 2 3]

[11 22 33]]

이번에는 DataFrame을 리스트와 딕셔너리로 변환해보자

tolist() : df -> 리스트로 변환

to_dict() : df -> 딕셔너리로 변환

#DataFrame을 리스트로 변환

list3 = df_dict.values.tolist() #tolist()메서드 이용

print('df_dict.values.tolist() 타입:', type(list3))

print(list3)

#DataFrame을 딕셔너리로 변환

dict3 = df_dict.to_dict('list') #to_dict()메서드 이용, 인자로 'list'를 입력하면 딕셔너리의 값이 리스트형으로 반환된다.

print('\n df_dict.to_dict()타입:', type(dict3))

print(dict3)

[output]

df_dict.values.tolist() 타입: <class 'list'>

[[1, 2, 3], [11, 22, 33]]

df_dict.to_dict()타입: <class 'dict'>

{'col1': [1, 11], 'col2': [2, 22], 'col3': [3, 33]}

[DataFrame의 칼럼 데이터 세트 생성과 수정]

DataFrame [] 내에 새로운 칼럼명을 입력하고 값을 할당해주기만 하면 된다.

이렇게 Series에 상숫값을 할당하면 Seires의 모든 데이터 세트에 일괄적으로 적용된다.

이번에는 기존 칼럼 Series의 데이터를 이용해 새로운 칼럼 Series를 만들어보자

DataFrame 내의 기존 칼럼 값도 쉽게 일괄적으로 업데이트 할 수 있다.

업데이트를 원하는 칼럼 Series를 DataFrame[] 내에 칼럼명으로 입력한 뒤에 값을 할당해주면 된다.

[DataFrame 데이터 삭제]

- DataFrame.drop() : 데이터 삭제의 메서드

* drop() 메서드의 원형

DataFrame.drop(lables = None, axis=0, index=None, colums=None, level=None, inplace=False, errors='raise')

이 중 가장 중요한 파라미터는 lables, axis, inplace이다.

앞의 넘파이에서 설명했듯이 2차원 ndarray는 로우 방향의 axis 0, 칼럼 방향의 axis 1이 있다.

DataFrame은 2차원 데이터로만 이루어져있기 때문에 axis 0, axis 1로만 구성되어있다.

따라서 drop()메서드에 axis =1을 입력하면 칼럼을 드롭하겠다는 의미이다.

lables에 원하는 칼럼명을 입력하고 axis=1을 입력하면 지정된 칼럼을 드롭한다.

drop()메서드에 axis= 0을 입력하면 로우를 드롭하는 의미이다.

DataFrame의 특정 로우를 가리키는 것은 인덱스이다.

그러므로 lables에 오는 값을 인덱스로 간주한다.

drop()메서드가 사용되는 대부분의 경우는 칼럼을 드롭하는 경우이다.

로우 레벨로 삭제를 하는 경우는 이상치 데이터를 삭제하는 경우에 주로 사용된다.

이번에는 또 하나의 주요 파라미터인 inplace에 대해 알아보자

먼저 원본 Titanic DataFrame을 보자

'Age_0' 칼럼이 존재하는 것을 확인할 수 있다.

Inplace = False이면 원본의 DataFrame은 유지하게된다.

Inplace = True로 설정하면 원본 DataFrame의 데이터도 삭제된다.

또한 여러 개의 칼럼을 삭제하고 싶으면 리스트 형태로 삭제하고자 하는 칼럼명을 lables 파라미터로 입력하면된다.

3개의 칼럼이 삭제된 것을 확인할 수 있다.

한 가지 유의할 점은, inplace=True로 설정하면 반환값이 None이 된다.

따라서 inplace=True로 설정한 채로 반환 값을 다시 자신의 DataFrame 객체로 할당하면 안된다.

이번에는 axis = 0으로 설정해 index 0,1,2 로우를 삭제해보자

# 로우 삭제

pd.set_option('display.width', 1000) # 표시할 가로의 길이

pd.set_option('display.max_colwidth', 15) # 한 칼럼의 넓이를 15로

print('####before axis 0 drop####')

print(titanic_df.head(3))

titanic_df.drop([0,1,2], axis=0, inplace=True) #원본 dataframe에 드롭된 결과를 적용

print('####after axis 0 drop####')

print(titanic_df.head(3))

[output]

####before axis 0 drop####

PassengerId Survived Pclass Name Sex Age SibSp Parch Ticket Fare Cabin Embarked

0 1 0 3 Braund, Mr.... male 22.0 1 0 A/5 21171 7.2500 NaN S

1 2 1 1 Cumings, Mr... female 38.0 1 0 PC 17599 71.2833 C85 C

2 3 1 3 Heikkinen, ... female 26.0 0 0 STON/O2. 31... 7.9250 NaN S

####after axis 0 drop####

PassengerId Survived Pclass Name Sex Age SibSp Parch Ticket Fare Cabin Embarked

3 4 1 1 Futrelle, M... female 35.0 1 0 113803 53.1000 C123 S

4 5 0 3 Allen, Mr. ... male 35.0 0 0 373450 8.0500 NaN S

5 6 0 3 Moran, Mr. ... male NaN 0 0 330877 8.4583 NaN Q

drop() 메서드에서 axis와 inplace 인자를 적용해 DataFrame을 변경하는 방식을 정리해보면,

- axis : DataFrame의 로우를 삭제할 때는 axis=0, 칼럼을 삭제할 때는 axis=1

- 원본 DataFrame을 유지하고 드롭된 DataFrame을 객체변수로 받고 싶다면 inplace=False로 설정(디폴트 값)

- 원본 DataFrame에 드롭된 결과를 적용할 경우에는 inplace=True 로 설정

- 원본 DataFrame에서 드롭된 DataFrame을 다시 원본 DataFrame 객체 변수로 할당하면 원본 DataFrame에서 드롭된 결과를 적용할 경우와 같음 (단, 기존 원본 DataFrame 객체 변수는 메모리에서 추후 제거 됨)

[Index 객체]

Index : DataFrame, Series의 레코드를 고유하기 식별하는 객체이다.

DataFrame, Series에서 index 객체만 추출하려면 df.index or series.index를 사용하면 된다.

#index 객체

#원본 파일 다시 로딩

titanic_df = pd.read_csv('titanic_train.csv')

#index객체 추출

indexes = titanic_df.index

print(indexes)

#Index 객체를 실제 값 array로 표현

print('Index 객체 array값:\n', indexes.values)

[output]

RangeIndex(start=0, stop=891, step=1)

Index 객체 array값:

[ 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17

18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35

36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53

54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71

72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89

90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107

108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125

126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143

144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161

162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179

180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197

198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215

216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233

234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251

252 253 254 255 256 257 258 259 260 261 262 263 264 265 266 267 268 269

270 271 272 273 274 275 276 277 278 279 280 281 282 283 284 285 286 287

288 289 290 291 292 293 294 295 296 297 298 299 300 301 302 303 304 305

306 307 308 309 310 311 312 313 314 315 316 317 318 319 320 321 322 323

324 325 326 327 328 329 330 331 332 333 334 335 336 337 338 339 340 341

342 343 344 345 346 347 348 349 350 351 352 353 354 355 356 357 358 359

360 361 362 363 364 365 366 367 368 369 370 371 372 373 374 375 376 377

378 379 380 381 382 383 384 385 386 387 388 389 390 391 392 393 394 395

396 397 398 399 400 401 402 403 404 405 406 407 408 409 410 411 412 413

414 415 416 417 418 419 420 421 422 423 424 425 426 427 428 429 430 431

432 433 434 435 436 437 438 439 440 441 442 443 444 445 446 447 448 449

450 451 452 453 454 455 456 457 458 459 460 461 462 463 464 465 466 467

468 469 470 471 472 473 474 475 476 477 478 479 480 481 482 483 484 485

486 487 488 489 490 491 492 493 494 495 496 497 498 499 500 501 502 503

504 505 506 507 508 509 510 511 512 513 514 515 516 517 518 519 520 521

522 523 524 525 526 527 528 529 530 531 532 533 534 535 536 537 538 539

540 541 542 543 544 545 546 547 548 549 550 551 552 553 554 555 556 557

558 559 560 561 562 563 564 565 566 567 568 569 570 571 572 573 574 575

576 577 578 579 580 581 582 583 584 585 586 587 588 589 590 591 592 593

594 595 596 597 598 599 600 601 602 603 604 605 606 607 608 609 610 611

612 613 614 615 616 617 618 619 620 621 622 623 624 625 626 627 628 629

630 631 632 633 634 635 636 637 638 639 640 641 642 643 644 645 646 647

648 649 650 651 652 653 654 655 656 657 658 659 660 661 662 663 664 665

666 667 668 669 670 671 672 673 674 675 676 677 678 679 680 681 682 683

684 685 686 687 688 689 690 691 692 693 694 695 696 697 698 699 700 701

702 703 704 705 706 707 708 709 710 711 712 713 714 715 716 717 718 719

720 721 722 723 724 725 726 727 728 729 730 731 732 733 734 735 736 737

738 739 740 741 742 743 744 745 746 747 748 749 750 751 752 753 754 755

756 757 758 759 760 761 762 763 764 765 766 767 768 769 770 771 772 773

774 775 776 777 778 779 780 781 782 783 784 785 786 787 788 789 790 791

792 793 794 795 796 797 798 799 800 801 802 803 804 805 806 807 808 809

810 811 812 813 814 815 816 817 818 819 820 821 822 823 824 825 826 827

828 829 830 831 832 833 834 835 836 837 838 839 840 841 842 843 844 845

846 847 848 849 850 851 852 853 854 855 856 857 858 859 860 861 862 863

864 865 866 867 868 869 870 871 872 873 874 875 876 877 878 879 880 881

882 883 884 885 886 887 888 889 890]

index의 식별성 데이터인 1차원 array도 ndarray와 유사하게 단일 값 반환 및 슬라이싱도 가능하다.

print(type(indexes.values)) #ndarray

print(indexes.values.shape) #(891,)

print(indexes[:5].values) #[0 1 2 3 4]

print(indexes.values[:5]) #[0 1 2 3 4]

print(indexes[6]) #6

[output]

<class 'numpy.ndarray'>

(891,)

[0 1 2 3 4]

[0 1 2 3 4]

6

하지만 한 번 만들어진 DataFrame, Series의 Index객체는 함부로 변경할 수 없다.

indexes[0]=5

[output]

---------------------------------------------------------------------------

TypeError Traceback (most recent call last)

<ipython-input-29-33f4b187a6bd> in <module>

----> 1 indexes[0]=5

~\anaconda3\lib\site-packages\pandas\core\indexes\base.py in __setitem__(self, key, value)

4079

4080 def __setitem__(self, key, value):

-> 4081 raise TypeError("Index does not support mutable operations")

4082

4083 def __getitem__(self, key):

TypeError: Index does not support mutable operations

Seires 객체는 Index객체를 포함하지만, 연산함수를 적용할 때 Index는 연산에서 제외된다.

Index는 오직 식별용이다!!

series_fair = titanic_df['Fare']

print('Fair Series max 값:', series_fair.max())

print('Fair Seires sum 값:', series_fair.sum())

print('sum() Fair Seires:', sum(series_fair))

print('Fair Series + 3:\n', (series_fair+3).head(3))

[output]

Fair Series max 값: 512.3292

Fair Seires sum 값: 28693.9493

sum() Fair Seires: 28693.949299999967

Fair Series + 3:

0 10.2500

1 74.2833

2 10.9250

Name: Fare, dtype: float64

- rest_index() : DataFrame 및 Series에 새롭게 인덱스를 연속 숫자 형으로 할당, 기존 인덱스는 'index'라는 새로운 칼럼명으로 추가됨

Series에 value_counts()를 수행하면 고유값이 식별자 인덱스 역할을 했다.

rest_index()를 추가하여 연속형 숫자형 인덱스를 추가해보자

이 때, 칼럼이 2개가 되므로 Series가 아닌 DataFrame이 반환된다는 것을 유의해야한다.

print('### before reset_index ###')

value_counts=titanic_df['Pclass'].value_counts()

print(value_counts) #Pclass 고유값이 식별자 인덱스 역할을 함

print('values_counts 객체 변수 타입:', type(value_counts)) #series

new_value_counts = value_counts.reset_index(inplace=False)# 연속형 인덱스 추가

print(new_value_counts)

print('new_value_counts 객체 변수 타입:', type(new_value_counts)) #DataFrame

[output]

### before reset_index ###

3 491

1 216

2 184

Name: Pclass, dtype: int64

values_counts 객체 변수 타입: <class 'pandas.core.series.Series'>

index Pclass

0 3 491

1 1 216

2 2 184

new_value_counts 객체 변수 타입: <class 'pandas.core.frame.DataFrame'>

rest_index()의 파라미터 중 drop=True로 설정하면 기존 인덱스는 새로운 칼럼으로 추가되지 않고 삭제된다.

즉 그대로 Series를 유지하게 된다.

[데이터 셀렉션 및 필터링]

판다스의 경우, 넘파이[]와 다르게 iloc[], loc[] 연산자를 통해 데이터를 가공하여 추출한다.

판다스의 []연산자와 넘파이의 []와 어떠한 차이가 있는지 먼저 알아보자.

1. DataFrame의 []연산자

넘파이에서 []연산자는 행의 위치, 열의 위치, 슬라이싱 범위 등을 지정해 데이터를 가져올 수 있다.

하지만 DataFrame의 []안에 들어갈 수 있는 것은 칼럼명 문자(또는 칼럼명 리스트 객체), 또는 인덱스로 변환 가능한 표현식이다.

즉, DataFrame 뒤에 있는 []는 칼럼만 지정할 수 있는 '칼럼 지정 연산자'라고 이해하는 것이 지금 수준에서는 좋다.

print('단일 칼럼 데이터 추출:\n', titanic_df['Pclass'].head(3))

print('\n여러 칼럼의 데이터 추출:\n', titanic_df[['Survived', 'Pclass']].head(3))

print('[] 안에 숫자 index는 KeyError 오류 발생:\n,', titanic_df[0]) # 오류 발생

[output]

단일 칼럼 데이터 추출:

0 3

1 1

2 3

Name: Pclass, dtype: int64

여러 칼럼의 데이터 추출:

Survived Pclass

0 0 3

1 1 1

2 1 3

---------------------------------------------------------------------------

KeyError Traceback (most recent call last)

KeyError: 0

판다스의 인덱스 형태로 변환 가능한 표현식은 []내에 입력할 수 있다. ex) 슬라이싱

불린 인덱싱 표현도 가능하다.

[] 내의 불린 인덱싱 기능은 원하는 데이터를 편리하게 추출해주므로 매우 자주 사용된다.

DataFrame의 []연산자의 입력인자가 여러가지 형태라 사용할 때 혼동이 될 수 있기에 이 가이드를 기억하자.

- DataFrame 바로 뒤의 []연산자는 넘파이의 []나, Series의 []와 다르다.

- DataFrame 바로 뒤의 [] 내 입력값은 칼럼명(또는 칼럼의 리스트)를 지정해 칼럼 지정 연산에 사용하거나 불린 인덱스 용도로만 사용해야 한다.

- DataFrame [0:2]와 같은 슬라이싱 연산으로 데이터를 추출하는 방법은 사용하지 않는 게 좋다.

2. DataFrame iloc[] 연산자

- iloc[] : 위치(Location) 기반 인덱싱 방식, 행과 열의 위치를, 0을 출발점으로 하는 세로축 , 가로축 좌표 정숫값으로 지정하는 방식

- loc[]: 명칭(Label) 기반 인덱싱 방식, 데이터 프레임의 인덱스 값으로 행 위치를, 칼럼의 명칭으로 열 위치를 지정

iloc[]는 위치 기반 인덱싱만 허용하기 때문에 행과 열의 좌표 위치에 해당하는 값으로 정숫값 또는 정수형의 슬라이싱, 팬시 리스트 값을 입력해줘야한다.

먼저 위 예제의 data_df의 첫번째 행과 열의 데이터를 iloc[]을 통해 추출해보자

data_df.iloc[0,0]

[output]

'Chulmin'

iloc[행 위치 정숫값, 열 위치 정숫값]과 명확하게 입력해야 해당 위치에 있는 데이터를 가져올 수 있다.

반면에 iloc[]에 DataFrame의 인덱스 값이나 칼럼명을 입력하면 오류를 발생시킨다.

#아래 코드는 오류를 발생시킨다.

data_df.iloc[0,'Name']

[output]

---------------------------------------------------------------------------

ValueError Traceback (most recent call last)

ValueError: Location based indexing can only have [integer, integer slice (START point is INCLUDED, END point is EXCLUDED), listlike of integers, boolean array] types

iloc[]는 열 위치에 -1을 입력하여 DataFrame의 가장 마지막 열 데이터를 가져오는 데 자주 사용한다.

print('\n 맨 마지막 칼럼 데이터[:,-1]\n',data_df.iloc[:,-1])

print('\n 맨 마지막 칼럼을 제외한 모든 데이터[:,:-1]\n', data_df.iloc[:,:-1])

[output]

맨 마지막 칼럼 데이터[:,-1]

one Male

two Female

three Male

four Male

Name: Gender, dtype: object

맨 마지막 칼럼을 제외한 모든 데이터[:,:-1]

Name Year

one Chulmin 2011

two Eunkyung 2016

three Jinwoong 2015

four Soobeom 2015

iloc[]는 슬라이싱과 팬시 인ㄴ덱싱은 제공하나 명확한 위치 기반 인덱싱이 사용되어야 하는 제약으로 불린 인덱싱은 제공하지 않는다.

3. DataFrame loc[] 연산자

loc[인덱스값, 칼럼명]과 같은 형식으로 데이터를 추출할 수 있다.

data_df.loc['one', 'Name']

[output]

'Chulmin'#다음 코드는 오류를 발생시킨다.

data_df.loc[0, 'Name'] #df에 0이라는 인덱스는 없기 때문

[output]

---------------------------------------------------------------------------

KeyError Traceback (most recent call last)

KeyError: 0

loc[]에 슬라이싱 기호 ':'을 적용할 때 시작값~ 종료값-1이 아닌 종료값까지 포함하는 것을 유의해야한다.

이는 명칭 기반 인덱싱의 특성 때문이다. 명칭은 숫자가 아니다 !!

print('위치기반 iloc slicing\n', data_df.iloc[0:1, 0], '\n')

print('명칭기반 loc slicing\n', data_df.loc['one':'two', 'Name'])

[output]

위치기반 iloc slicing #한 개의 행 반환

one Chulmin

Name: Name, dtype: object

명칭기반 loc slicing # 2개의 행 반환

one Chulmin

two Eunkyung

Name: Name, dtype: object

[], lioc[], loc[]의 특징과 주의할 점을 정리해보자

- 개별 또는 여러 칼럼 값 전체를 추출하고자 한다면 iloc[], loc[]을 사용하지 않고 data_df['Name']과 같이 DataFrame['칼럼명']만으로 충분하다. 하지만 행과 열을 함께 사용항 데이터를 추출해야 한다면 iloc[]나 loc[]를 사용해야 한다.

- iloc[]와 loc[]을 이해하기 위해서는 명칭 기반 인덱싱과 위치 기반 인덱싱 차이를 먼저 이해해야 한다. DataFrame의 인덱스나 칼럼명으로 데이터에 접근하는 것은 명칭 기반 인덱싱이다. 0부터 시작하는 행, 열의 위치 좌표에만 의존하는 것이 위치 기반 인덱싱이다.

- iloc[]는 위치기반 인덱싱만 가능하다. 따라서 행과 열 윛치 값으로 정수형 값을 지정해 원하는 데이터를 반환한다.

- loc[]는 명칭기반 인덱싱만 가능하다. 따라서 행 위치에 DataFrame의 인덱스가 오며, 열 위치에는 칼럼명을 지정해 원하는 데이터를 반환한다.

- 명칭기반 인덱싱에서 슬라이싱을 '시작점:종료즘'으로 지정할 때 시작점에서 종료점을 포함한 위치에 있는 데이터를 반환한다.

[불린 인덱싱]

불린인덱싱은 매우 편리한 데이터 필터링 방법이다.

iloc, loc은 로직이나 조건에 의해 계산한 뒤에 행 위치, 열 위치 값으로 입력되는데, 그럴 필요 없이 처음부터 가져올 값을 조건으로 []에 입력하게 되면 자동으로 원하는 값을 필터링한다.

불린인덱싱은 [],loc[]에서만 공통으로 지원한다.

[] 내에 불린 인덱싱을 적용하면 반환되는 객체가 DataFrame이므로 원하는 칼럼명만 별도로 추출할 수 있다.

loc[]를 이용해도 동일하게 적용할 수 있다. 단, ['Name', 'Age']는 칼럼위치에 놓아야한다.

여러개의 복합조건도 할당할 수 있다.

- and ==> &

- or ==> |

- Not ==> ~

다음과 같이 개별 조건을 변수에 할당하고 이들 변수를 결합해서 불린 인덱싱을 수행할 수도 있다.

[정렬, Aggregation 함수, GroupBy 적용]

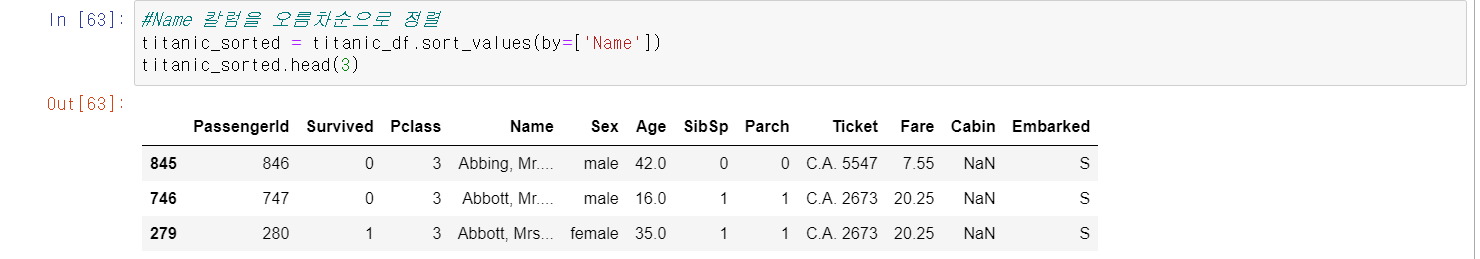

1. DataFrame, Series의 정렬 - sort_values()

- sort_values(): 정렬을 수행하는 메서드

* by 파라미터는 특정 칼럼을 입력하면 해당 칼럼으로 정렬 수행

* ascending=True 오름차순 정렬 ascending=False 내림차순 정렬 (디폴트 값 True)

* inplace=True 원본 그대로 유지 (디폴트값)

2. Aggregation 함수 적용

DataFrame에서 바로 aggregation을 호출할 경우 모든 칼럼에 해당 aggregation을 적용한다.

titanic_df.count()

[output]

PassengerId 891

Survived 891

Pclass 891

Name 891

Sex 891

Age 714 #count()는 null값을 반영하지 않음

SibSp 891

Parch 891

Ticket 891

Fare 891

Cabin 204

Embarked 889

dtype: int64

특정 칼럼에 aggregation을 적용하기 위해서는 DataFrame에 대상 칼럼들만 추출해 aggregation을 적용하면 된다.

titanic_df[['Age', 'Fare']].mean()

[output]

Age 29.699118

Fare 32.204208

dtype: float64

3. groupby() 적용

DataFrame에서 groupby() 사용 시 입력 파라미터 by에 칼럼을 입력하면 대상 칼럼으로 groupby 된다.

DataFrame에 groupby()를 호출하면 DataFrameGroupBy라는 또 다른 형태의 객체 DataFrame을 반환한다.

titanic_groupby = titanic_df.groupby(by='Pclass')

print(type(titanic_groupby))

[output]

<class 'pandas.core.groupby.generic.DataFrameGroupBy'>

DataFrame에 groupby()를 호출해 반한된 결과에 aggrregation함수를 호출하면 groupby() 대상 칼럼을 제외한 모든 칼럼에 해당 aggregation 함수를 적용한다.

DataFrame의 groupby()에 특정 칼럼만 aggregation 함수를 적용하려면 groupby()로 반환된 DataFrameGroupBy 객체에 해당 칼럼을 필터링한 뒤 aggregation 함수를 적용해야한다.

DataFrame groupby()의 경우 적용하려는 여러 개의 aggregation 함수명을 DataFrameGroupBy 객체의 agg()내에 인자로 입력해 사용한다.

각 칼럼마다 서로 다른 aggregation 함수를 groupby에서 호출하려면 agg()내에 입력값으로 딕셔너리 형태로 적용될 칼럼들과 함수를입력해야한다.

[결손 데이터 처리하기]

결손 데이터는 칼럼에 값이 없는 Null인 경우를 의미하며, 이를 넘파이의 NaN으로 표시한다.

기본적으로 머신러닝 알고리즘은 이 NaN값을 처리하지 않으므로 이 값을 다른 값으로 대체해야한다.

1. isna()로 결손 데이터 여부 확인

- isna(): 데이터가 NaN인지 아닌지를 True, False로 알려준다.

결손 데이터의 개수는 isna()결과에 sum()함수를 추가해 구할 수 있다.

sum()을 호출 시 True = 1, False = 0으로 변환되므로 결손 데이터 개수를 구할 수 있다.

titanic_df.isna().sum()

[output]

PassengerId 0

Survived 0

Pclass 0

Name 0

Sex 0

Age 177

SibSp 0

Parch 0

Ticket 0

Fare 0

Cabin 687

Embarked 2

dtype: int64

2. fillna()로 결손 데이터 대체하기

타이타닉 데이터 세트의 'Cabin'칼럼의 NaN값을 'C000'으로 대체해보자

주의해야할 점은 fillna()를 이용해 반환 값을 다시 받거나 inplace = True 파라미터를 fillna()에 추가해야 실제 데이터 세트 값이 변경된다는 점이다.

'Age' 칼럼의 NaN값을 평균 나이로, 'Embarked'칼럼의 NaN값을 's'로 대체해 모든 결손 데이터를 처리해보자

titanic_df['Age'] = titanic_df['Age'].fillna(titanic_df['Age'].mean())

titanic_df['Embarked'] = titanic_df['Embarked'].fillna('S')

titanic_df.isna().sum()

[output]

PassengerId 0

Survived 0

Pclass 0

Name 0

Sex 0

Age 0

SibSp 0

Parch 0

Ticket 0

Fare 0

Cabin 0

Embarked 0

dtype: int64

[apply lambda 식으로 데이터 가공]

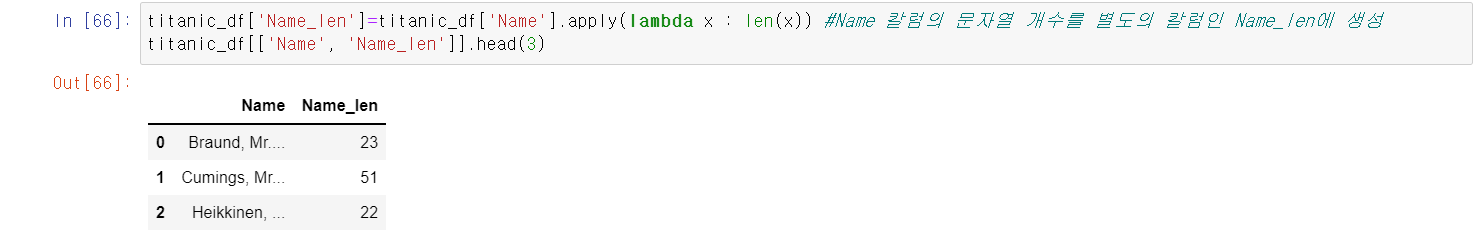

판다스는 apply 함수에 lambda 식을 결합해 DataFrame이나 Series의 레코드별로 데이터를 가공하는 기능을 제공한다.

lambda 식에 대해 먼저 설명해보자면,

가령 다음과 같이 입력값의 제곱값을 구해서 반환하는 get_square(a)라는 함수가 있다고 가정해보자

def get_square(a):

return a**2

print('3의 제곱은:', get_square(3))

[output]

3의 제곱은: 9

lambda는 이러한 함수의 선언과 함수 내의 처리를 한 줄의 식으로 쉽게 변환하는 식이다.

lambda_square = lambda x : x**2

print('3의 제곱은:', lambda_square(3))

[output]

3의 제곱은: 9

lambda x : x**2에서 ':'로 입력인자와 반환될 입력인자의 계산식을 분리한다.

':'의 왼쪽에 있는 x는 입력인자를 가리키며, 오른쪽은 입력인자의 계산식이다. 즉, 반환값을 의미하는 것이다.

lambda 식을 이용할 때 여러 개 값을 입력 인자로 사용해야 할 경우에는 map()함수를 결합해 사용한다.

a = [1,2,3]

squares = map(lambda x : x**2, a)

list(squares)

[output]

[1, 4, 9]

이제 DataFrame의 apply에 lambda 식을 적용해 데이터를 가공해보자

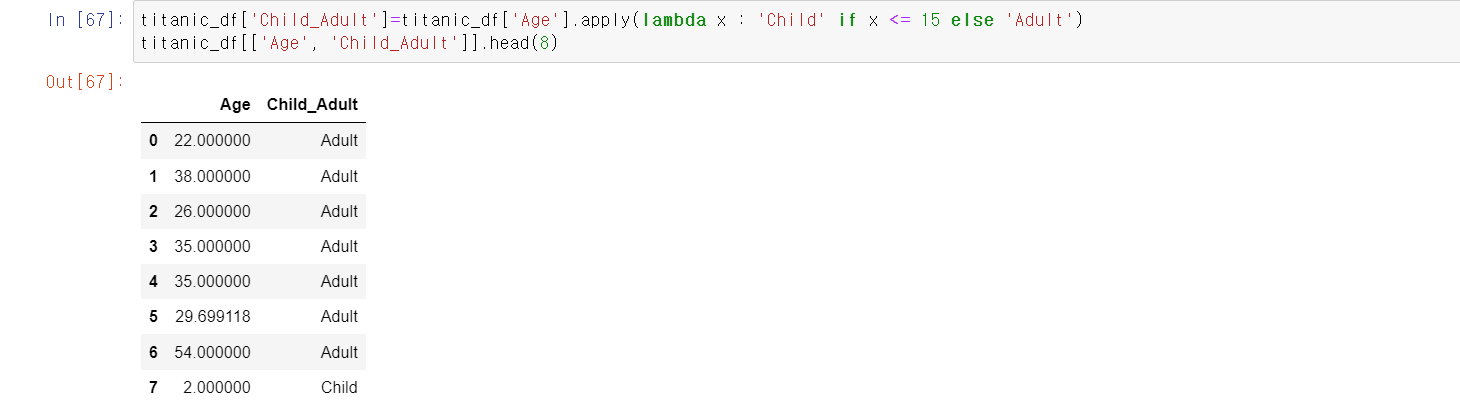

if else 절을 사용해 좀 더 복잡한 가공을 해보자

주의해야할 점은 if 절의 경우 ':'보다 오른편에 반환값이 있어야 하기 때문에 if 식보다 반환 값을 먼저 기술해야 한다.

또 한가지는 if, else 만 지원하고 if, else if, else와 같이 else if는 지원하지 않는다.

else if를 이용하기 위해서는 else절을 ()로 내포해 () 내에서 다시 if else를 적용해 사용한다.

나이가 15세 미만이면 child, 15~60세 사이는 Adult, 61세 이상은 Elderly로 분류하는 'Age_Cat' 칼럼을 만들어보자

titanic_df['Age_cat'] = titanic_df['Age'].apply(lambda x : 'Child' if x<=15 else('Adult'if x<=60 else 'Elderly'))

titanic_df['Age_cat'].value_counts()

[output]

Adult 786

Child 83

Elderly 22

Name: Age_cat, dtype: int64

그런데 else if가 많이 나와야하는 경우나 switch case문의 경우에는 이렇게 else를 계속 내포해서 쓰기 어렵다.

이 경우 아예 별도의 함수를 만드는 게 더 나을 수 있다.

실제로 ML 모델을 생성하고 예측을 수행하는 데 있으서 ML알고리즘이 차지하는 비중보다 데이터를 전처리하고 피처를 가공/추출하는 부분이 훨씬 많은 비중을 차지하게 된다.

따라서 뒤에서 배울 사이킷런에 대한 이해도 중요하지만 넘파이, 판다스, 맷플롯립/시본과 같이 파이썬 머신러닝 생태계를 이루고 있는 다양한 패키지에 대한 이해 역시 매우 중요하다.

Ref) 파이썬 머신러닝 완벽가이드